📜기본 숙제 : Ch.04(04-1) 2번 문제 풀고, 풀이 과정 설명하기

Q. 로지스틱 회귀가 이진 분류에서 확률을 출력하기 위해 사용하는 함수

A. 시그모이드 함수

;하나의 선형 방정식의 출력값을 0~1 사이의 값으로 압축

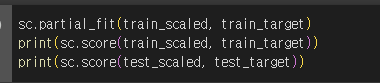

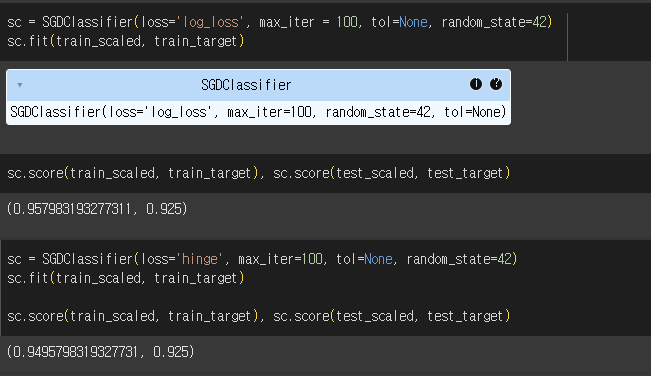

📜 추가 숙제 : Ch.04(04-2) 과대적합/과소적합 손코딩 코랩 화면 캡쳐하기

🔖 Chap04. 다양한 분류 알고리즘

4.1 로지스틱 회귀

1) 럭키백의 확률

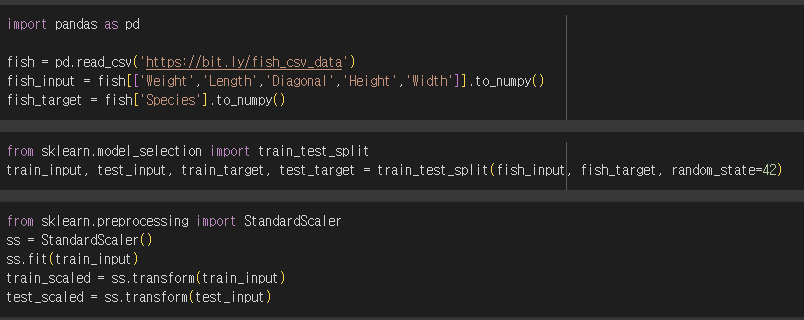

- 데이터 준비하기

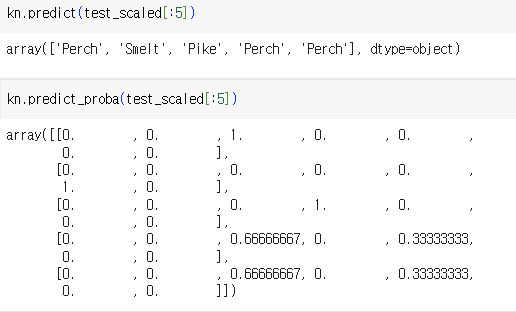

- K-최근접 이웃 분류기의 확률 예측

2) 로지스틱 회귀

- 선형 회귀와 동일하게 선형 방정식을 학습

- 이진분류 : 시그모이드

- 하나의 선형 방정식의 출력값을 0~1 사이의 값으로 압축

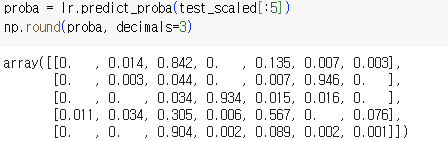

- 로지스틱 회귀로 다중 분류 수행하기

- 다중 분류 : 소프트맥스

- 여러 개의 선형 방정식의 출력값을 0~1 사이로 압축하고 전체 합이 1이 되도록 한다.

- 정규화된 지수함수라고도 한다.

4.2 확률적 경사 하강법

1) 점진적인 학습

- 점진적 학습, 온라인 학습 : 앞서 훈련한 모델을 버리지 않고, 새로운 데이터에 대해서만 조금씩 훈련하기

- 확률적 경사 하강법

- 훈련 세트에서 랜덤하게 하나의 샘플을 선택하여 가파른 경사를 조금 내려간다.

- 훈련 세트에서 랜덤하게 또 다른 샘플을 하나 선택하여 경사를 조금 내려간다.

- 전체 샘플을 모두 사용할 때까지 계속한다.

- 에포크 : 확률적 경사 하강법에서 훈련 세트를 한 번 모두 사용하는 과정

- 미니배치 경사 하강법

- 여러 개의 샘플을 사용해서 경사 하강법을 수행하는 방식

- 배치 경사 하강법

- 한 번 경사로를 따라 이동하기 위해 전체 샘플을 사용

2) 손실 함수

- 어떤 문제에서 머신러닝 알고리즘이 얼마나 엉터리인지 측정하는 기준

- 로지스틱 손실 함수 (이진 크로스엔트로피 손실 함수)

- 양성 클래스(탸깃 = 1)일 때 손실을 -log(예측 확률)로 계산

- 음성 클래스(타깃 = 0)일 때 손실을 -log(1-예측 확률)로 계산

- 크로스 엔트로피 손실 함수

- 다중 분류에서 사용하는 손실 함수

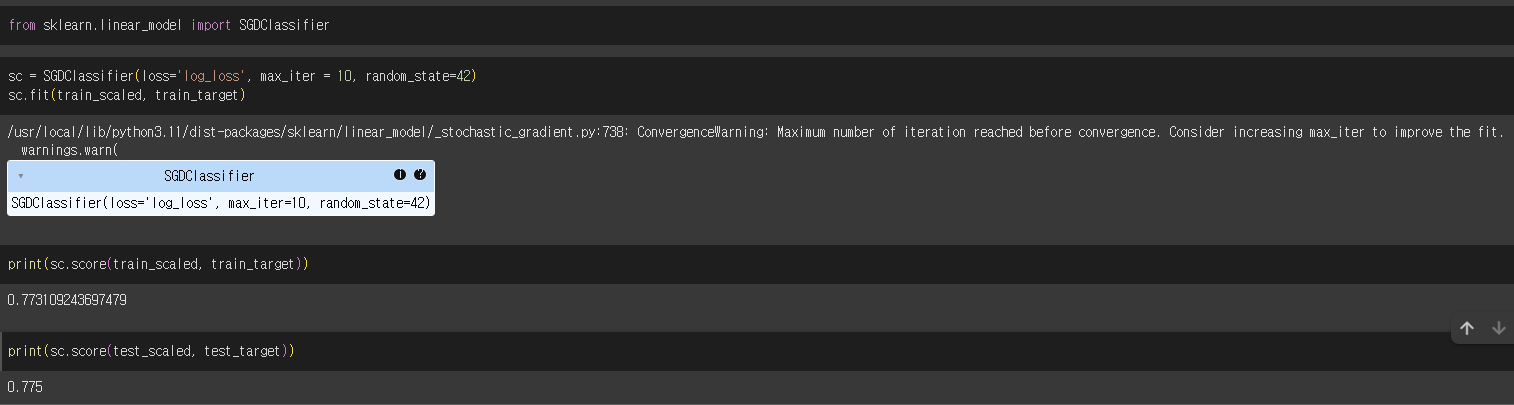

3) SGDClassifier

4) 에포크와 과대/과소적합

💭 느낀 점

수업시간에 배운 내용을 다시 볼 수 있어서 좋았습니다!

'독학 > [책] 머신러닝+딥러닝' 카테고리의 다른 글

| [혼공학습단 13기 혼공머신🤖] 혼자 공부하는 머신러닝 + 딥러닝 week6 (0) | 2025.02.18 |

|---|---|

| [혼공학습단 13기 혼공머신🤖] 혼자 공부하는 머신러닝 + 딥러닝 week5 (0) | 2025.02.11 |

| [혼공학습단 13기 혼공머신🤖] 혼자 공부하는 머신러닝 + 딥러닝 week4 (0) | 2025.02.06 |

| [혼공학습단 13기 혼공머신🤖] 혼자 공부하는 머신러닝 + 딥러닝 week2 (0) | 2025.01.19 |

| [혼공학습단 13기 혼공머신🤖] 혼자 공부하는 머신러닝 + 딥러닝 week1 (0) | 2025.01.12 |