📜기본 숙제 : Ch.07(07-1) 확인 문제 풀고, 풀이 과정 정리하기

Q1. 어떤 인공 신경망의 입력 특성이 100개이고 밀집층에 있는 뉴런 개수가 10개일 때 필요한 모델 파라미터의 개수는 몇 개인가요?

A1. 1010

;100 * 100 + 10

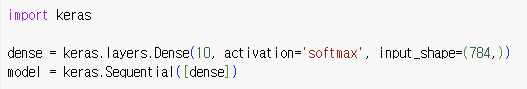

Q2. 케라스의 Dense 클래스를 사용해 신경망의 출력층을 만들려고 합니다. 이 신경망이 이전 분류 모델이라면 activation 매개변수에 어떤 활성화 함수를 지정해야 하나요?

A2. sigmoid

;출력층의 뉴런의 한 개이고 선형 방정식의 결과를 확률로 변경하기 위해 sigmoid 를 이용

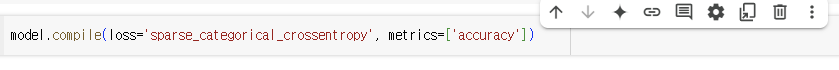

Q3. 케라스 모델에서 손실 함수와 측정 지표 등을 지정하는 메서드는 무엇인가요?

A3. compile()

; loss 매개변수로 손실함수를 지정하고, metrics 매개변수에서 측정하려는 지표를 지정

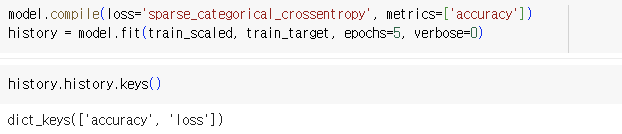

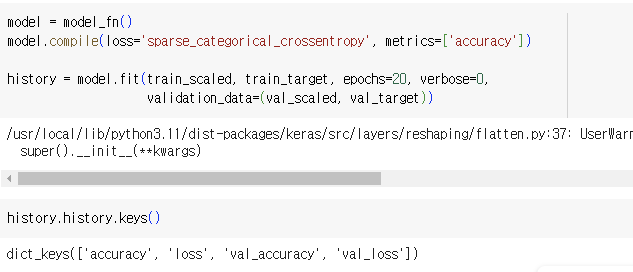

Q4. 정수 레이블을 타겟으로 가지는 다중 분류 문제일 때 케라스 모델의 complie() 메서드에 지정할 손실 함수로 적절한 것은 무엇인가요?

A4. sparse_categorical_crossentropy

; 타겟값이 정수인 다중분류일 경우 sparse_categorical_crossentropy로 지정

📜 추가 숙제 : Ch.07(07-2) 확인 문제 풀고, 풀이 과정 정리하기

Q1. 다음 중 모델의 add() 메서드 사용법이 올바른 것은?

A1. model.add(keras.layers.Dense(10, activation='relu'))

; 매개변수로 층의 객체를 전달해야 한다.

Q2.크기가 300 * 300인 입력을 케라스 층으로 펼치려고 한다. 다음 중 어떤 층을 사용해야 하나요?

A2.Flatten

; 배치 차원을 제외한 입력의 차원을 일렬로 펼칠려면 Flatten 클래스를 사용

Q3. 다음 중에서 이미지 분류를 위한 심층 신경망에 널리 사용되는 케라스의 활성화 함수를 무엇인가요?

A3. relue

; relu는 이미지 처리 작업에서 많이 쓰인다.

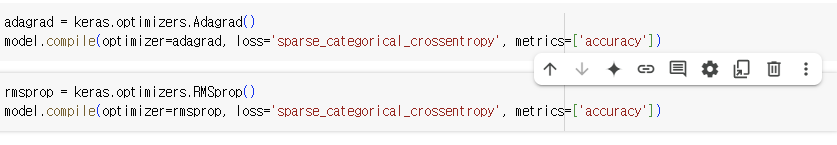

Q4. 다음 중 적응적 학습률을 사용하지 않는 옵티마이저는 무엇인가요?

A4. SGD

; 기본 경사하강법과 모멘텀 등을 구현한 클래스로, 일정한 학습률을 사용한다.

🔖 Chap07. 딥러닝을 시작합니다

7.1 인공 신경망

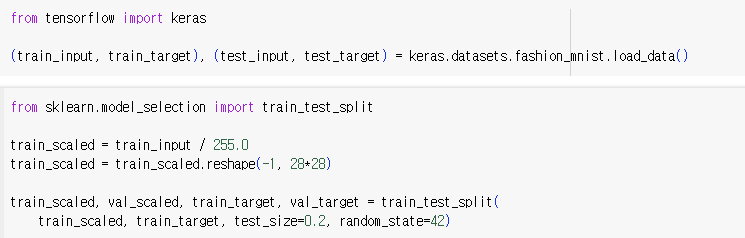

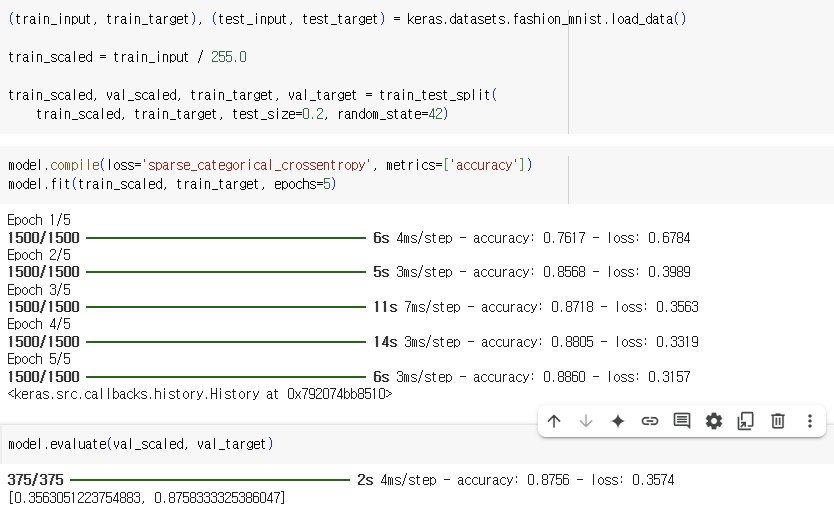

1) 패션 MNIST

- 텐서플로우를 사용해 데이터를 불러온다.

2) 로지스틱 회귀로 패션 아이템 분류하기

3) 인공 신경망

- 출력층 : 클래스를 예측하기 위해 신경망의 최종 값을 만듦.

- 뉴런(=유닛) : Z값을 계산하는 단위

- 입력층 : 픽셀 값 자체로 특별한 계산을 수행하지 않음.

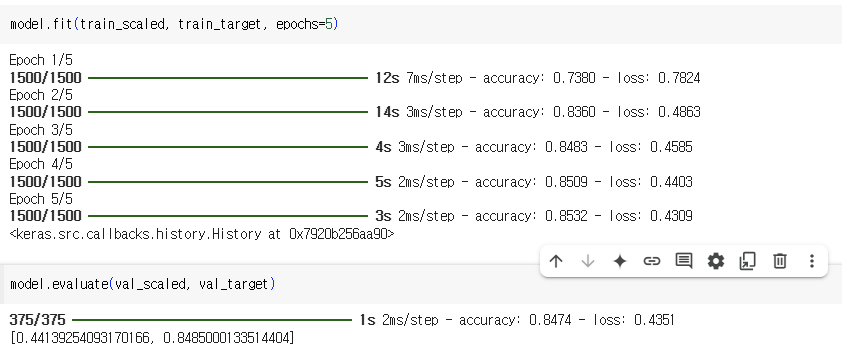

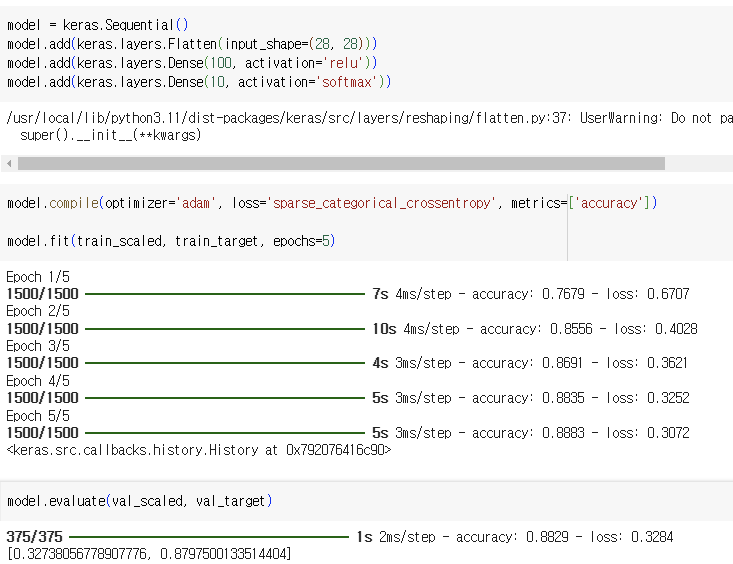

4) 인공 신경망으로 모델 만들기

5) 인공 신경망으로 패션 아이템 분류하기

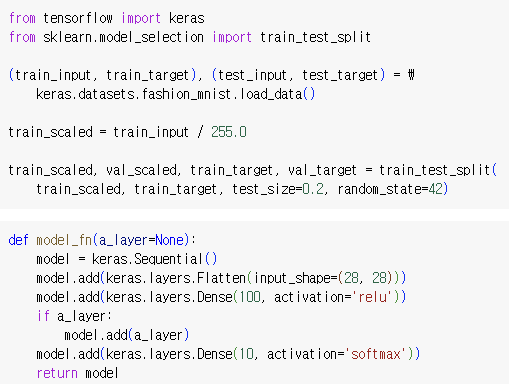

7.2 심층 신경망

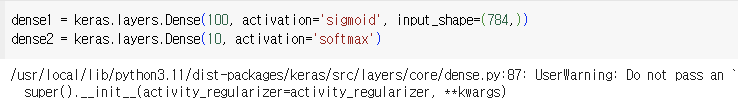

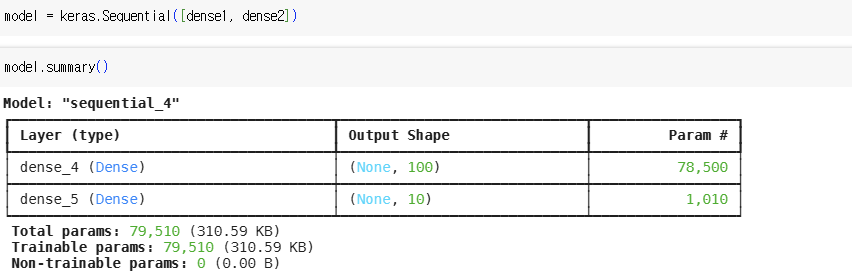

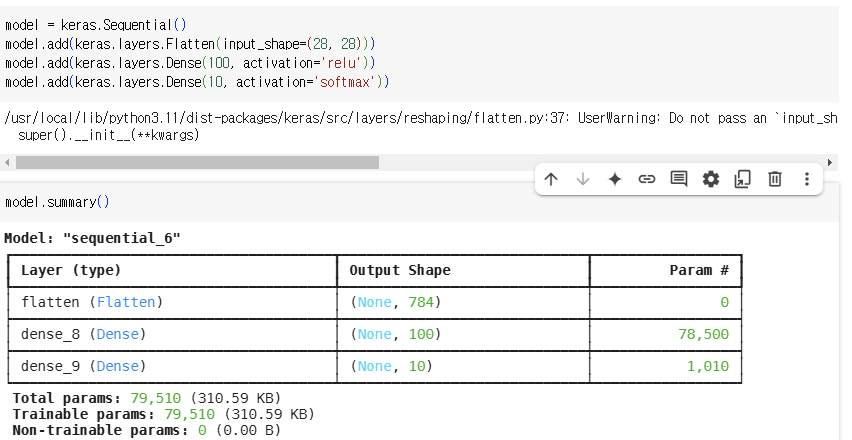

1) 2개의 층

- 은닉층 : 입력층과 출력층 사이에 있는 모든 층

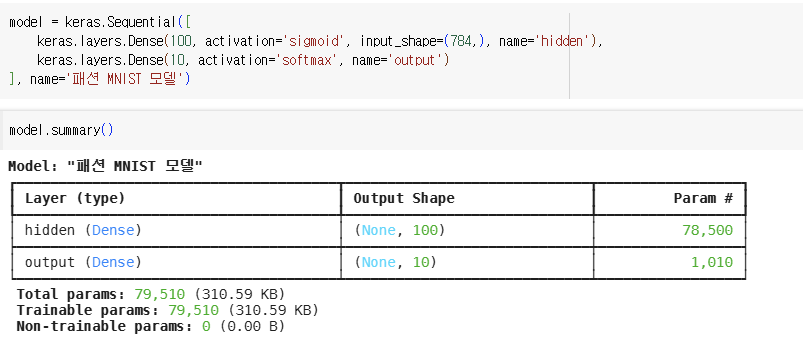

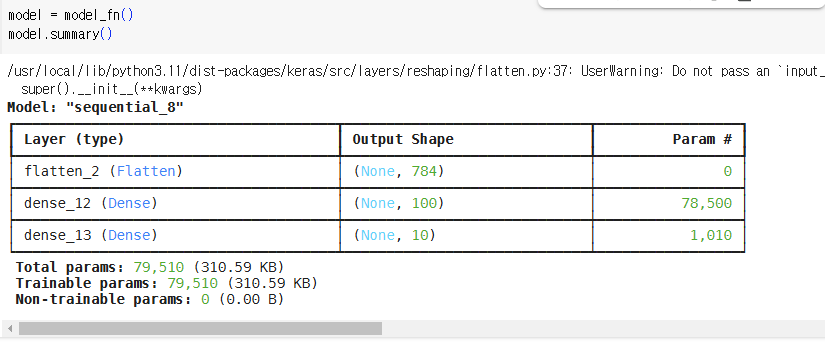

2) 심층 신경망 만들기

3) 층을 추가하는 다른 방법

4) 렐루 함수

ReLu(z) = max(0, z)

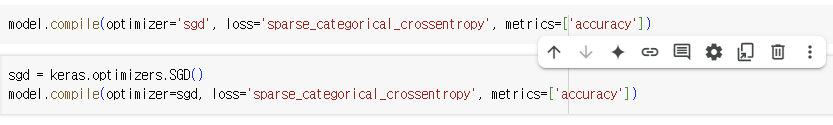

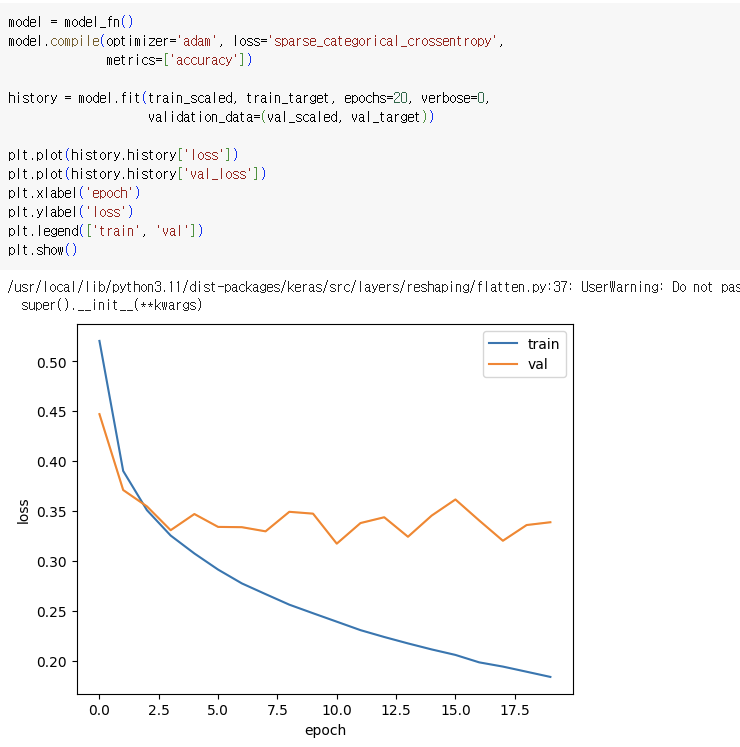

5) 옵티마이저

- 케라스에서 제공하는 경사 하강법 알고리즘

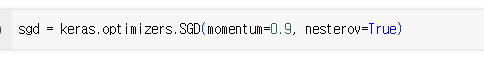

- 모멘텀 최적화 : 이전의 그레이디언트를 가속도처럼 사용

- 네스테로프 모멘텀 최적화 : 모멘텀 최적화를 2번 반복하여 구현

- 적응적 학습률 : 모델이 최적점에 가까이 갈수록 학습률을 감소시킴

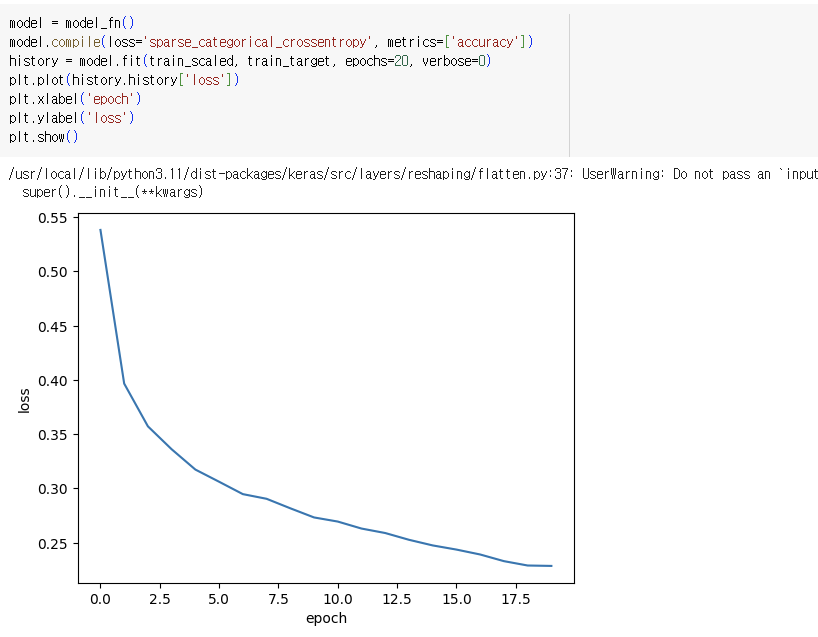

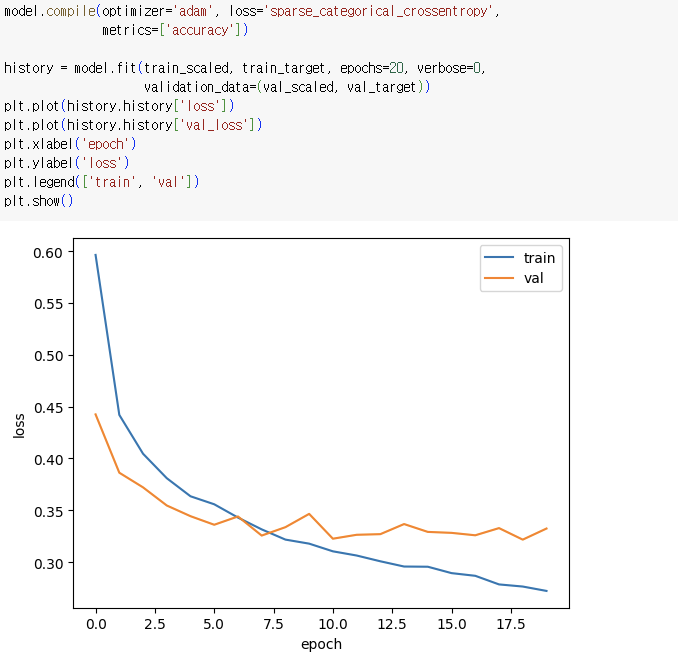

ex) Adam 클래스의 매개변수 기본값을 이용하여 패션 MNIST 모델을 훈련

7.3 신경망 모델 훈련

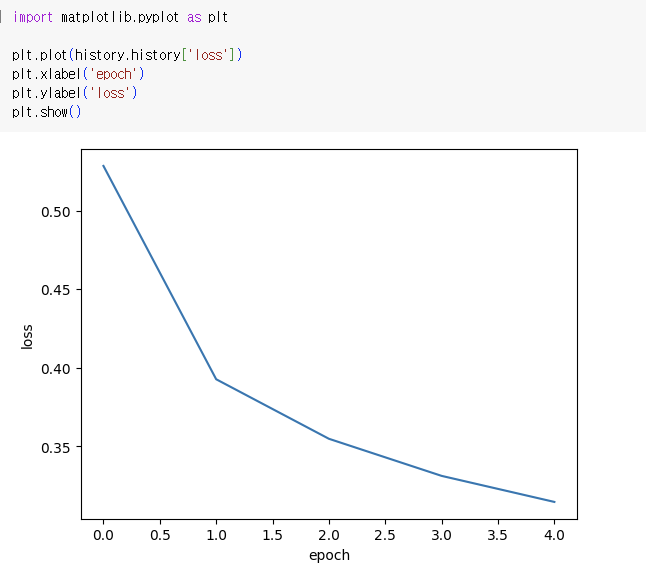

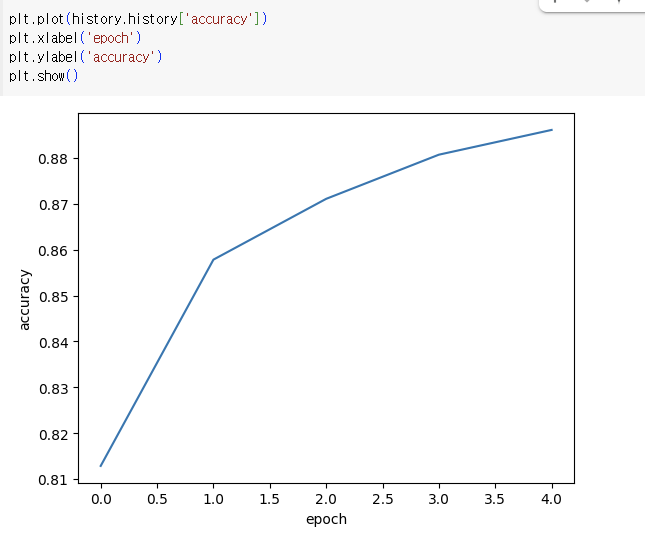

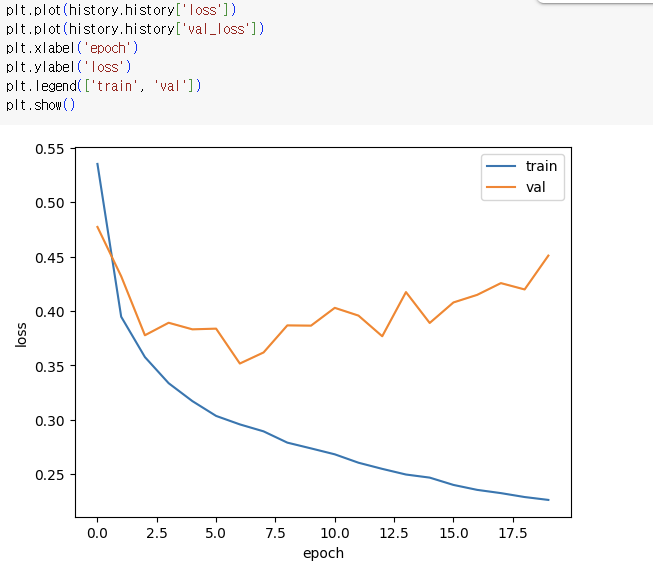

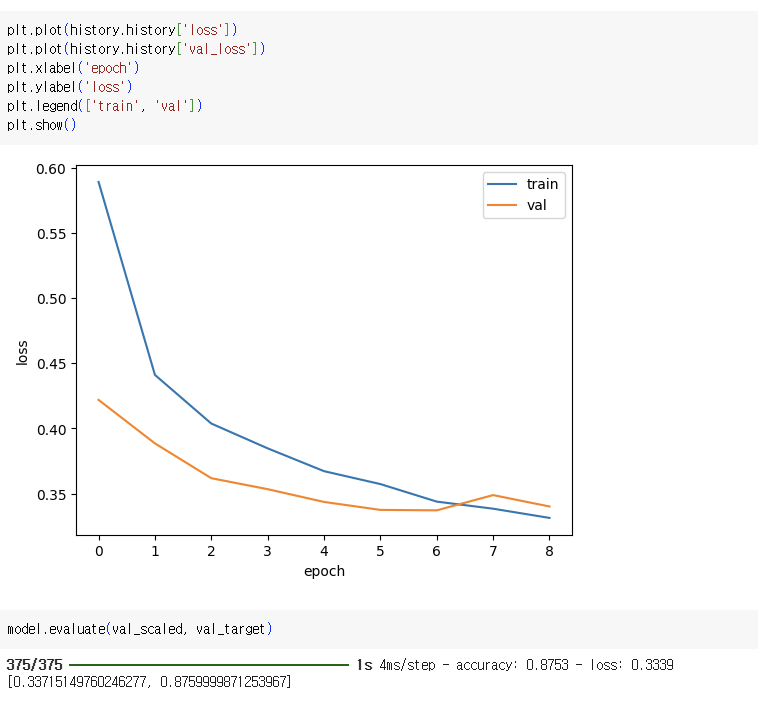

1) 손실 곡선

2) 검증 손실

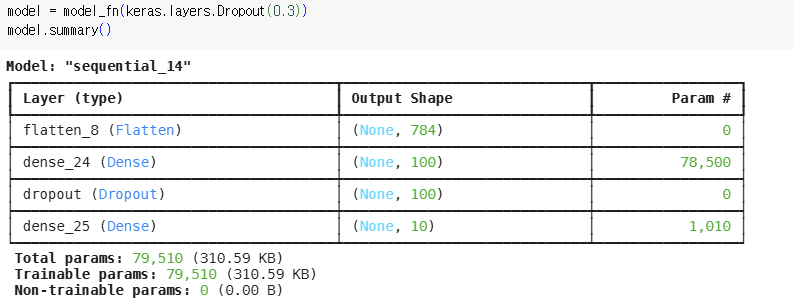

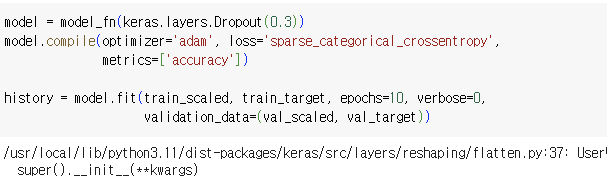

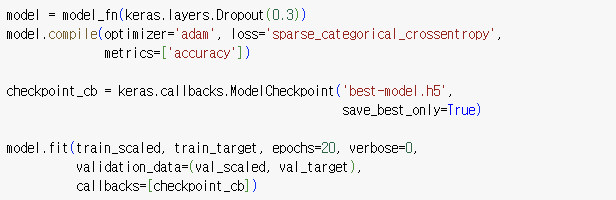

3) 드롭아웃

- 훈련 과정에서 층에 있는 일부 뉴런을 랜덤하게 꺼서 과대적합을 막음.

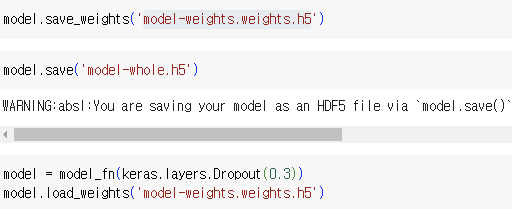

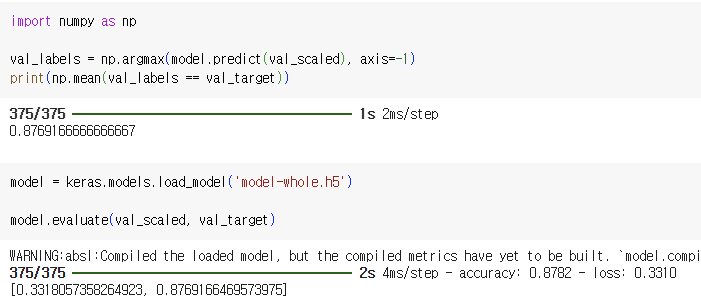

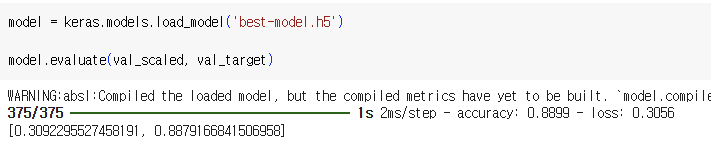

4) 모델 저장과 복원

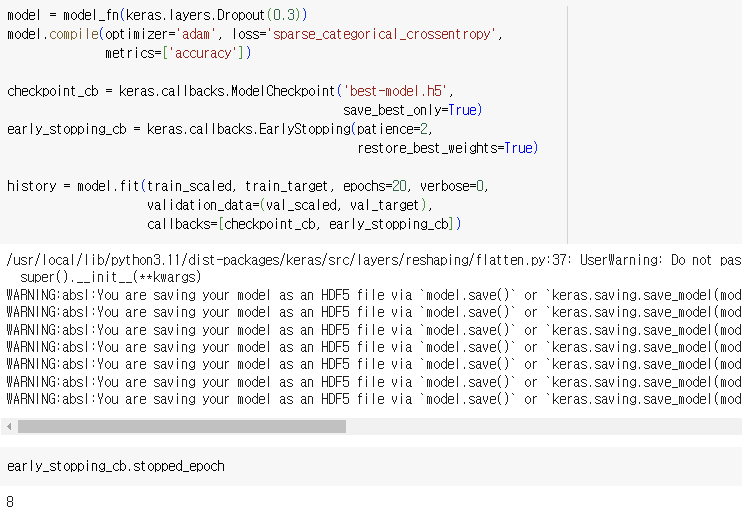

5) 콜백

- 조기 종료 : 과대적합이 시작되기 전에 훈련을 미리 중지시키는 것

💭 느낀 점

새롭게 배워가는 것이 많았던 한 주였습니다. 이렇게 6주동안의 학습이 끝났네요! 남아 있는 장들도 조금씩 공부해보려고 합니다.

'독학 > [책] 머신러닝+딥러닝' 카테고리의 다른 글

| [혼공학습단 13기 혼공머신🤖] 혼자 공부하는 머신러닝 + 딥러닝 week5 (0) | 2025.02.11 |

|---|---|

| [혼공학습단 13기 혼공머신🤖] 혼자 공부하는 머신러닝 + 딥러닝 week4 (0) | 2025.02.06 |

| [혼공학습단 13기 혼공머신🤖] 혼자 공부하는 머신러닝 + 딥러닝 week3 (0) | 2025.01.24 |

| [혼공학습단 13기 혼공머신🤖] 혼자 공부하는 머신러닝 + 딥러닝 week2 (0) | 2025.01.19 |

| [혼공학습단 13기 혼공머신🤖] 혼자 공부하는 머신러닝 + 딥러닝 week1 (0) | 2025.01.12 |